服务器负载均衡是如何工作的?

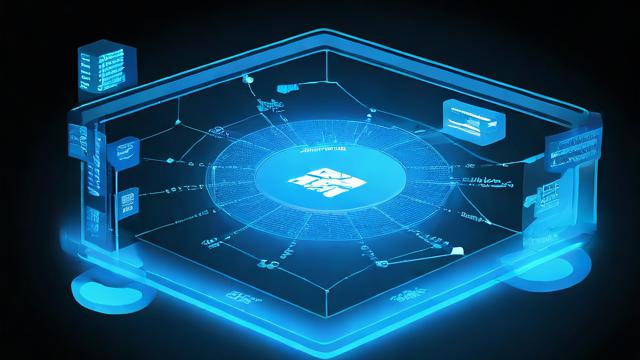

服务器负载均衡是一种在多台服务器之间分配网络流量和应用请求的技术,旨在提高系统的性能、可靠性和可扩展性,以下是关于服务器负载均衡的详细解释:

一、基本概念

定义:服务器负载均衡通过将传入的请求分散到多个服务器上,确保每台服务器都承担适量的工作,从而避免单点故障和性能瓶颈。

目的:提升整体系统的处理能力,增强用户体验,并确保服务的高可用性和稳定性。

二、工作原理

1、接收请求:客户端(如浏览器或应用程序)向服务器发送请求。

2、分发请求:负载均衡器作为中介,接收这些请求并根据预设的算法将它们分配给最合适的后端服务器。

3、处理请求:后端服务器接收请求并进行处理,然后将响应返回给负载均衡器。

4、返回响应:负载均衡器将后端服务器的响应返回给客户端。

三、常见算法

轮询(Round Robin):按照顺序将请求依次分配给每台服务器,适用于服务器性能相近的场景。

加权轮询(Weighted Round Robin):根据服务器的性能或权重来分配请求,性能更好的服务器会处理更多的请求。

最少连接数(Least Connections):将请求分配给当前连接数最少的服务器,适用于处理长连接请求的场景。

IP哈希(IP Hash):根据客户端的IP地址计算哈希值,将请求分配给特定的服务器,适用于需要保持客户端会话一致性的场景。

四、实现方式

硬件负载均衡器:使用专门的硬件设备来实现负载均衡功能,功能强大但成本较高。

软件负载均衡器:依赖于开源解决方案或商业软件来实现负载均衡功能,灵活性更高且相对经济,常见的软件负载均衡器包括Nginx、HAProxy等。

五、重要性

1、提升性能和响应速度:通过合理分配请求,减少单台服务器的压力,提高整体处理能力。

2、增强系统可用性和容错能力:当某台服务器出现故障时,负载均衡器可以自动将流量转发至其他正常运行的服务器,确保服务的连续性。

3、便于扩展和维护:随着业务的发展,可以通过添加更多的服务器来轻松扩展系统的处理能力,同时负载均衡的机制也使得服务器的维护工作更加灵活。

服务器负载均衡是现代网络架构中不可或缺的一部分,它通过优化资源使用、提升性能和保证可用性为用户提供了顺畅的体验。

各位小伙伴们,我刚刚为大家分享了有关“服务器负载均衡什么意思”的知识,希望对你们有所帮助。如果您还有其他相关问题需要解决,欢迎随时提出哦!

暂无评论,1人围观